Como escolher qual IA utilizar sem perder a sanidade

Evitando a analysis paralysis na hora de escolher o modelo adequado para cada tarefa.

Com a profusão de modelos de Inteligência Artificial1 sendo lançados numa cadência frenética e praticamente impossível de acompanhar, começamos a sentir os sintomas da analysis paralysis, fenômeno conhecido por todos que ingenuamente já se propuseram a escolher um filme na Netflix (efeito acentuado pela presença de uma segunda pessoa, tipicamente uma esposa).

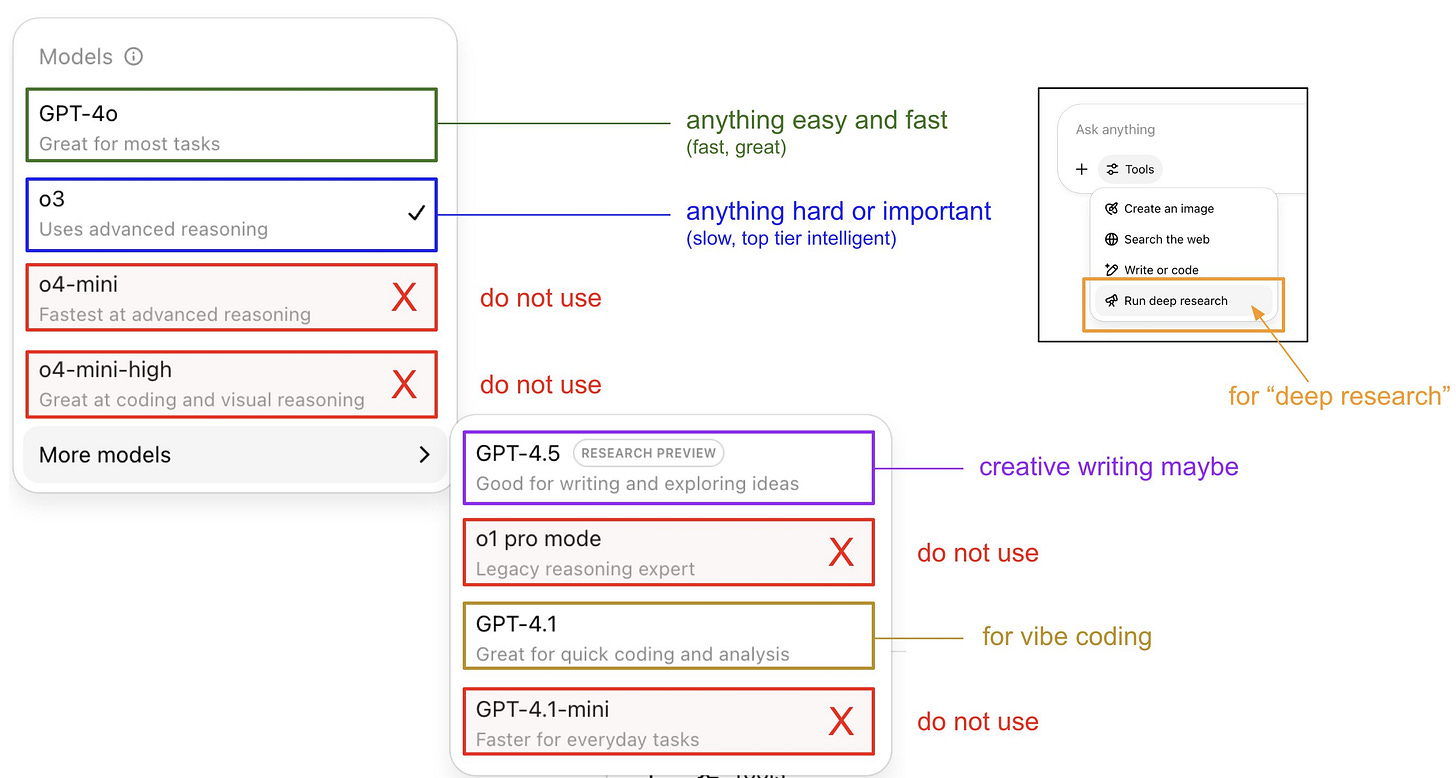

No momento que escrevo, o menu seletor de modelos do ChatGPT apresenta 8 (!) opções, inclusive o recém-lançado o3-pro. Não obstante a quantidade, os nomes parecem parecem uma tentativa de causar uma dislexia coletiva: 4o, o4, 4.5, 4.1, 4.1-mini, etc.

Essa praga não acomete apenas a OpenAI. Os modelos do Google – Flash e Pro – são numerados como 2 e 2.5, e muitas vezes diferenciados pelo dia de lançamento. Hoje temos o Gemini 2.5 Pro 05-06 e o Gemini 2.5 Pro 06-05 (é sério).

Desabafos à parte, é realmente uma tarefa difícil mapear cada necessidade a um modelo específico, e é isso que me proponho a fazer. Evidentemente, a velocidade de mudança das IAs é tão assustadora que tudo que disser aqui pode envelhecer muito rapidamente. Ainda que seja esse o caso, aproveitemos enquanto possível, e que pelo menos haja esse registro histórico de quão impressionante são as mudanças nessa época que estamos vivendo.

Gostaria de estabelecer três casos de uso principais para as IAs: consultas genéricas, resolução de problemas, e programação.

Mas antes, caso prefira uma versão em vídeo deste artigo, considere assistir diretamente no YouTube:

Consultas genéricas

Essa categoria é o que tradicionalmente foi papel do Google. Costumam ser queries específicas como “Pai Nosso em latim”, “próximo jogo do Brasil nas Eliminatórias” ou “como fazer um pudim”. Nesse caso, prezamos majoritariamente pela velocidade da resposta, e dedicamos pouco ou nenhum tempo a formular a pergunta decentemente (isto é, ajustar o prompt).

Outra característica desse tipo de consulta é normalmente ter uma resposta bem definida, com baixo grau de variabilidade. A resposta é mais ou menos conhecida, e mesmo que haja subjetividade (como no caso do pudim), não nos preocupamos tanto com a razão por trás da resposta (você não busca uma análise científica do porquê tal método de se preparar um pudim é melhor que outro).

Para esse tipo de tarefa, é difícil bater o modelo 4o do ChatGPT. De fato, a própria OpenAI classifica-o como “great for most tasks”. É o daily driver, o motorzinho do seu dia. Particularmente, utilizo frequentemente o app do ChatGPT, tanto no celular quanto no computador, como suporte rápido no meu dia a dia (foi assim que pesquisei a definição de analysis paralysis para garantir que não estava falando bobagem).

Resolução de problemas

Essa categoria é uma das mais impactantes pois permite que tenhamos uma ou mais soluções para problemas complexos, algo que não é tão simples de se chegar à conclusão. É como ter acesso instantâneo à alguém extremamente inteligente e versado em diversos assuntos.

Como as questões desse tipo são open-ended, escrever um prompt adequado passa a ser extremamente importante. Além disso, é importante municiar a IA com dados que a ajudem a propor soluções específicas. Por exemplo, se eu quiser traçar um plano para atingir 1000 seguidores no Substack em 6 meses, é prudente que eu inclua no prompt minha disponibilidade de tempo, as estatísticas dos meus artigos publicados até hoje, quais performaram melhor, a taxa de abertura dos emails, etc.

Nesse caso as IAs entram no modo reasoning, muitas vezes modulado por um thinking budget, que nada mais é do que o poder computacional disponível para que o modelo refine cada vez mais sua resposta. São exemplos de modelos de reasoning o ChatGPT o3 (e agora o o3-pro, bem mais lento mas com maior capacidade computacional) e o Gemini 2.5 Pro.

Aqui também passa a ser importante o acesso a tools, ou seja, ferramentas que o modelo possa decidir utilizar para ajudar no “raciocínio”. Acesso à internet, execução de código e integração com outras ferramentas (Gmail, Google Drive, etc) são exemplos de tools.

Para esse tipo de problema tenho utilizado quase exclusivamente o ChatGPT o3. É incrível seu poder analítico e capacidade de criar e executar códigos de forma autônoma. Um caso onde fiquei particularmente impressionado foi quando exportei vários megabytes de artigos sobre futebol e pedi para ele gerar uma lista de categorias que abarcassem todos os textos (uma espécie de clusterização). Mesmo o número de dados ultrapassando e muito a context window, o modelo foi capaz de executar um código Python e propor as categorias. Em contraste, o Gemini 2.5 Pro, ainda que com 4x mais “espaço na memória”, não resolveu o problema por estourar a janela.

Programação

Finalmente chegamos ao uso mais corriqueiro, e talvez mais revolucionário, das IAs. Aqui me refiro a modelos otimizados para geração de código, justamente onde temos mais opções: todos os modelos Gemini, todos os modelos do Claude (Opus e Sonnet), e o4-mini, o4-mini-high e 4.1 do ChatGPT.

Hoje (com bastante ênfase na noção temporal, ou seja, amanhã pode ser diferente), os modelos do Claude são meus preferidos. Na verdade, já há algum tempo, e principalmente depois da introdução do Claude Opus 4, cujo único defeito é consumir minha quota rápido demais.

Sempre que desejo programar uma feature mais complexa, ou quero dar um zelo maior no código, minha opção principal é o Claude Opus 4 através do Claude Code. Quando estou trabalhando no Cursor, costumo utilizar o Gemini 2.5 Pro simplesmente para evitar gastar todo meu limite na Anthropic (normalmente para mudanças mais auto-contidas). E se quero rapidamente prototipar algo, tirar alguma dúvida, ou criar um script, escolho o o4-mini-high pela velocidade e assertividade (embora a dificuldade de prover o contexto adequado torne-o pouco atrativo para qualquer projeto mais intrincado).

Claude Code é caro, caótico mas divertido

Quando a Anthropic anunciou sua nova CLI, o Claude Code, eu não fiquei nem um pouco empolgado. Sinceramente, não entendi o sentido. Por que programar via CLI se já temos algo decente dentro de uma IDE completa como o Cursor?

Outros casos relevantes

Existem alguns casos específicos onde alguns modelos se mostram superiores. Creio valer a pena mencioná-los também.

Analisar vídeos do YouTube

Quando precisamos analisar informações de um vídeo no YouTube o Gemini é de longe a melhor opção por integrar-se nativamente, sendo capaz não só de transcrever o texto, como também de entender as imagens. É realmente impressionante e descrevi esse processo no post abaixo.

Contextos maiores

É possível que queiramos adicionar muito dado ao modelo, por exemplo ao solicitar uma alteração em um repositório muito grande (ferramentas como Repomix ajudam a transformar um codebase num arquivo só, AI-friendly), ou analisar múltiplos PDFs de uma só vez. Nesses casos, o Gemini, por ter uma context window de 1M de tokens, é o mais indicado. No entanto, como já dito, muitas vezes mais vale um modelo de posse das tools adequadas do que simplesmente fazer um dump de dados.

Revisão de escrita e tradução

Escrever com IA é uma desgraça, e muitas vezes tira o propósito da escrita. No entanto, ainda mais quando se produz sozinho, é útil realizar uma espécie de proof-read, onde o modelo pode colaborar encontrando frases mal construídas, ou erros de ortografia.

Tais modelos são também extremamente úteis em traduções, até de artigos inteiros. Por exemplo, o meu post sobre impressões iniciais sobre o Codex, escrito originalmente em Português, foi traduzido de forma praticamente irretocável para o inglês, onde postei no meu blog original. Digo irretocável não porque a IA cometeria erros de ortografia, mas porque fez uma tradução compatível e natural, se aproximando do meu estilo de escrita e usando um vocabulário compatível com o meu.

Para esses casos acima considero o modelo 4.5 do ChatGPT indiscutivelmente o mais adequado.

O que aprendi usando o Codex, o agente de programação da OpenAI

Quando a OpenAI apresentou o Codex, confesso não ter ficado muito impressionado. Afinal, tenho sido um heavy user do Claude Code, cujo modelo de AI voltado para programação me parece bem superior. Além disso, são tantas ferramentas surgindo dia sim dia também que é necessário dar um basta e focar em uma coisa só.

Embora obviamente este post retrate minhas preferências, não é sem alegria que encontro muita interseção com outras pessoas do meio. Por exemplo e de modo mais marcante, o próprio Andrej Karpathy, já mencionado neste blog quando falei sobre vibe coding, expôs seu workflow no Twitter, consideravelmente similar ao que disse aqui e no vídeo (que, diga-se de passagem, foi publicado antes do tweet. Andrej, if you are reading me, say hi!).

Eu poderia continuar falando aqui de muitos outros casos de uso: geração de imagens, geração de títulos para ensaios (típicos do Substack) ou de títulos para vídeos (como no YouTube). Considero uma benção que tantas tarefas possam hoje ser auxiliadas por IAs tão poderosas, ainda que seja necessário estabelecer alguns limites claros. Tais limites, no entanto, serão tratados em um próximo artigo.

Quando me refiro à IA, estou querendo falar LLMs, ou Large Language Models, e deliberadamente deixando de lados outras formas de Inteligência Artificial.