Todos os MCPs que utilizo para programar

7 MCPs gratuitos e poderosos para quem programa com o auxílio da IA.

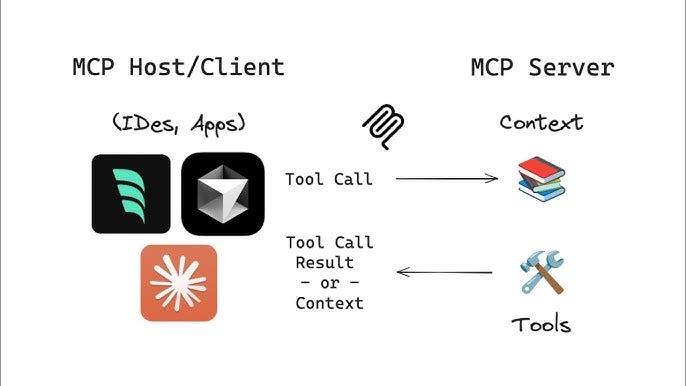

Confesso que quando os MCPs foram anunciados pela Anthropic, ainda em 2024, dei pouca importância. No entanto, 2025 tem sido o ano dos agentes, e como o lançamento do GPT-5 deixou bem claro, o maior avanço não está em ter o modelo mais “inteligente”, mas aquele capaz de prover maior interoperabilidade.

Interfaces como o Claude Code se integram harmonicamente aos MCPs. Afinal, em um único cliente, guiado por linguagem natural, é possível fazer (quase) tudo: modificar arquivos, realizar buscas na internet, procurar a documentação mais atualizada, acessar o banco de dados, operar o navegador… de fato, o workflow fica simples, focado e produtivo.

Nesse artigo não quero explorar o que é um MCP, ou todas suas válidas questões de segurança, mas compilar aqueles que tenho utilizado diariamente, na prática, em meus projetos. No YouTube, meu vídeo falando sobre MCPs alcançou rapidamente e com folga o posto de mais assistido do canal, portanto continuo a conversa por aqui, inclusive estendendo a lista original com outros servidores que entraram em meu radar após a publicação do vídeo.

Todos os MCPs listados são gratuitos (ainda que alguns dos serviços com que eles se conectam possam ser pagos) e funcionam no seu cliente favorito: Claude Code, Cursor, Windsurf, VS Code, etc.

1. Playwright

Playwright é minha escolha padrão para end-to-end testing e web scraping “tradicional” (ou seja, sem utilizar a IA. Mais sobre isso em breve). O fato de ser um fork do Puppeteer, que era minha escolha no passado, e tanto ele quanto seu servidor MCP serem mantidos oficialmente pela Microsoft, torna sua escolha um no brainer.

Esse MCP é particularmente útil para aqueles que trabalham com frontend (área que sou oriundo). Enquanto no backend é mais fácil para uma IA garantir que um código está funcionando através de unit tests, no frontend isso é mais complicado. Você pode testar que ao clicar um botão algo acontece, mas quem garante que o botão está acessível na página? Com o Playwright você consegue escrever um código que simula a ação “física” de um usuário, e com o MCP você estende essa capacidade pro LLM.

Sendo assim, ao trabalhar na UI do seu app, você pode utilizar o MCP do Playwright para solicitar à IA que, tendo terminado, efetivamente rode um browser, navegue até a página modificada e execute as ações necessárias. O modelo pode então se autocorrigir até que a tarefa esteja completa.

2. Context7

Um dos grandes problemas da IA generativa para programação era a alucinação, ou seja, quando o modelo te responde algo que não existe. Isso é particularmente comum em tecnologias mais modernas, ou atualizações recentes de ferramentas já estabelecidas (por muito tempo foi impossível trabalhar com Tailwind v4 uma vez que os LLMs haviam sido pesadamente treinados na v3).

O MCP do context7 resolve esse problema oferencendo um hub das documentações mais atualizadas das suas bibliotecas favoritas. Assim, basta instalar o MCP e solicitar algo como “use context7 to pull the latest docs from Next.js” e pronto – o contexto estará preenchido com informações atualizadas, e o código fluirá de forma muito natural.

Esse é provavelmente o MCP que mais utilizo. Veja que ele não indexa apenas as maiores e mais famosas bibliotecas: no vídeo acima, mostro um exemplo onde puxo os dados atualizados do react-use-websockets para resolver um bug identificado no Sentry.

3. Sentry

Falando em Sentry, é digno mencionar seu servidor MCP. Para quem não conhece, Sentry é um monitor de performance e error tracker muito comum em aplicações web. Ele captura erros durante a execução do código, de modo que você possa corrigi-los.

Utilizando seu MCP permite que você estabeleça um workflow do tipo “use the Sentry MCP to load details about the issue XYZ, fetch docs for the libraries involved from context7 and create a PR with the fix”. É extremamente poderoso e conveniente se você já usa essa ferramenta.

4. Gemini MCP Tool

Quando o Google lançou o Gemini CLI, muitos se perguntaram se ele seria capaz de substituir o Claude Code (até fiz um vídeo sobre o assunto). A expectativa era grande uma vez que o Claude Code pode sair bem caro e a nova CLI contava com 100 requisições free por dia, além de suportar uma janela de contexto de até um milhão de tokens.

A poeira baixou e o Gemini CLI se provou limitado em relação ao seu concorrente da Anthropic. No entanto, as requisições gratuitas e o contexto virtualmente ilimitado ainda podem ser úteis – se bem utilizadas. E a melhor forma que achei para isso foi através do gemini-mcp-tool.

Essa ferramenta gratuita e open source expõe uma conexão direta à CLI do Gemini para outro cliente MCP: o Claude Code. A grande utilidade disso é preservar o contexto e economizar significativamente em algumas tarefas mais exploratórias.

Por exemplo, sempre que trabalho num PR já existente gosto de pedir à IA que carregue todas as mudanças feitas até o momento no seu contexto. Essa é uma forma de garantir que os padrões utilizados serão respeitados. Se o PR for grande o suficiente, isso pode ser feito com o Gemini, que irá retornar a resposta para o Claude Code sem gastar seu precioso e caro contexto.

Outro bom uso são prompts exploratórios. Ao explorar uma codebase você pode perguntar algo do tipo “write me a comprehensive guide on how we handle cache in this repo”. O que tomaria tokens (e consequentemente dinheiro) em outros clientes, pode ser feito de graça com o Gemini. E de posse do guia, você pode utilizar um modelo mais capaz (como o Sonnet 4, Opus 4.1 ou GPT-5) para programar.

Expliquei esse workflow na prática em outro vídeo no YouTube.

5. Firecrawl

Uma grata surpresa foi ter descoberto recentemente o Firecrawl e seu servidor MCP. Esse serviço é um scraper que utiliza IA para retornar os dados em formatos convenientes para serem processados por um LLM (como markdown, HTML e JSON).

O que impressiona no Firecrawl é a facilidade de uso e a velocidade do scraper, que é inteligente para carregar sites dinâmicos (oferencendo uma alternativa mais lightweight ao Playwright) e até para bypassar CAPTCHAs. Outra vantagem é que pelo fato do scraping ser semântico (uma vez que é feito via IA), os códigos são mais duráveis e não quebrarão se a estrutura da página mudar (algo que já enfrentei muito criando scrapers para o QuantBrasil).

Como MCP, o Firecrawl é uma alternativa mais robusta ao context7 se a informação que você precisa não é apenas uma documentação, mas o scraping de um site ou uma busca mais completa na web. Particularmente, vejo mais utilidade em utilizar o Firecrawl programaticamente.

Um disclaimer: eu fui admitido no programa de creators do Firecrawl portanto se você quiser testá-lo e fizer através do link de afiliados, estará ajudando essa humilde newsletter. Mas convém dizer que eu me inscrevi no programa, não eles que me chamaram. E fiz isso pois fiquei positivamente impactado com a capacidade da ferramenta.

6. Linear

Os dias de domínio do JIRA ficaram no passado, e é raro encontrar um desenvolvedor que não goste do Linear. Pudera: sua abordagem dev oriented é ímpar no meio, e naturalmente eles foram um dos primeiros a oferecer um servidor MCP.

Os ganhos aqui são óbvios. Estando conectado ao Linear, você pode facilmente ingerir dados sobre um ticket no seu cliente, e começar o desenvolvimento imediatamente. Eis um workflow que gosto de seguir utilizando o Claude Code no plan mode: “use the Linear MCP to retrieve all data about the ticket ENG-1234 and draft a implementation plan”.

7. Postgres

Existem diversas implementações de servidores MCP que se conectam diretamente ao banco de dados. Sim, eu sei, nesse momento você está se contorcendo de horror com a perspectiva de oferecer acesso a um LLM… você não está errado, mas calma, deixe eu explicar.

O Postgres MCP Server tem um setup bem simples e uma implementação que por padrão permite apenas leituras, o que minimiza o problema de segurança. Ele foi criado por Eric Zakariasson, do time de desenvolvimento do Cursor, e está ainda nos estágios iniciais.

Porém o acesso direto ao DB, se feito de forma responsável, é uma vantagem substancial durante o desenvolvimento. Por exemplo, ao desenvolver uma API que insere algo no banco, você pode solicitar à IA que confira se o registro de fato está lá. Meu caso de uso favorito é pedir que o modelo entenda o schema das tabelas antes de propor uma mudança.

Essa integração permite o uso de um cliente MCP como o Cursor e o Claude Code como uma interface de data science. Combine o acesso ao banco com a capacidade de escrever Jupyter Notebooks e você consegue fazer análises com dados reais e utilizando linguagem natural. Imagine algo do tipo “use the postgres MCP to load the registration date of the last 1000 users and plot the distribution by day of the week in a Jupyter notebook”. É extremamente poderoso, em que pese as óbvias questões de segurança.

Convém dizer que todos os exemplos oferecidos poderiam ser feito sem MCPs. O Linear expõe um botão “Copiar em markdown”, você pode buscar a documentação mais atualizada manualmente no site da ferramenta, é possível exportar o schema de um banco de dados diretamente do Postgres, etc.

No entanto, a grande vantagem dos servidores MCPs é a conveniência, manter o desenvolvedor no flow, reduzir o custo cognitivo de alternar entre tarefas e capacitar a IA com as ferramentas necessárias para cumprir seu objetivo com qualidade. De fato, MCPs vieram para ficar e são mais um superpoder que julgo devermos aceitar de bom grado.

Estou configurando um servidor local com Kimi K2 full na 4090 (24 GB VRAM) e Claude como fallback. A ideia é economizar tokens processando o grosso localmente e só escalar para Claude quando houver necessidade (ex.: raciocínio extenso ou geração de documentos formais). Também pretendo usar RAG com banco vetorial para reduzir contexto e custo em cloud. Alguma recomendação para otimizar ainda mais esse balanceamento?